IL y a une pléiade de logiciels permettant d'aspirer un site internet sur son ordinateur, mais quand on peut faire plus simple, et plus rapide, pourquoi se priver.

Cette simple petite ligne de commande vous permet de récupérer le contenu Front d'un site lorsque les accès FTP ne sont pas disponibles ( chose fréquente lorsqu'un client change de prestataire ....). Pratique pour faire une copie sur un serveur distant

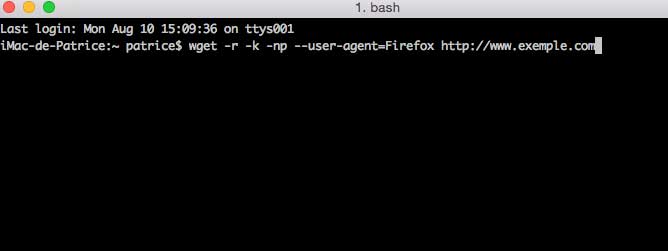

wget -r -k -np --user-agent=Firefox http://www.exemple.com

Comme souvent, l'option -r indique la récursivité de l'opération. wget suivra tous les liens de la page

L'option -k permet de réécrire les liens du site, pour que votre copie soit consultable localement. Les liens sont donc modifiés et pointe sur votre serveur local

-np empêche de remonter le répertoire. user-agent, et bien c'est pour se faire passer pour un internaute utilisant le navigateur Firefox, afin de s'assurer de recevoir une copie consultable depuis un navigateur classique

Le principal avantage de cette commande, c'est que vous ne monopolisez pas votre connexion adsl/fibre pour cette opération, et, suivant votre hébergeur, profitez d'une bande passante de 1 Gb/s. De quoi fortement diminuer la durée de votre copie.

Vous pouvez aussi utiliser httrack :

httrack "exemple.com" -O "/tmp/exemple" "+*.exemple.com/*" -v